András Tilcsik: La paradoja del progreso: Por qué fallan nuestros sistemas y lo que podemos hacer para evitarlo

Entrevistas

KC

Karen Christensen

Business Review (Núm. 280) · Márketing · Julio 2018

Management & Innovation (Núm. 29) · Márketing · Octubre 2020

El coautor de 'Meltdown: Why Our Systems Fail and What We Can Do About It' describe los elementos comunes de los fallos sistémicos y cómo afrontarlos

No suele pasar ni una semana sin que haya varios "desastres" en distintos lugares del mundo. Su investigación demuestra que estos incidentes comparten un ADN común. ¿Nos puede explicar esto?

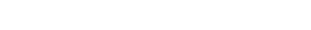

Si analizamos atentamente los distintos tipos de fallos que observamos –desde percances en el transporte o accidentes industriales hasta desastres en sistemas informáticos–, las causas subyacentes resultan sorprendentemente similares. Hay dos características comunes en los sistemas más susceptibles a este tipo de fallo –donde una serie de pequeños desarreglos se combinan con errores humanos menores, dando como consecuencia que el sistema entero deja de funcionar–.

La primera es la complejidad, lo que significa que el sistema no es, en sí mismo, lineal: es más bien como una red compleja –y mucho de lo que sucede queda oculto a la mirada humana–. Por ejemplo, no podemos mandar a alguien a ver qué es lo que sucede en el núcleo de un reactor nuclear, igual que no podemos mandar a alguien al fondo del océano cuando realizamos una perforación para extraer petróleo. No son solo las grandes organizaciones industriales las que se enfrentan a este problema: las empresas normales son cada vez más complejas, con componentes que interactúan entre sí de manera oculta e imprevisible.

La segunda característica común de los sistemas vulnerables es una estrecha vinculación. Este es un término de ingeniería con el que se designan los sistemas con una vinculación muy ceñida. En la práctica, eso significa que no queda apenas margen de error. Si hay un incidente, no tendremos apenas tiempo para averiguar lo que sucede y corregirlo. No podremos decir: "¡Tiempo muerto! Voy a salir de la situación y averiguar lo que está pasando, y después volveré a entrar para subsanarlo".

La teoría dice que cuando un sistema reúne esas dos condiciones –complejidad y estrecha vinculación–, será muy susceptible a fallos que nos cogerán desprevenidos y adquirirán rápidamente una dimensión desproporcionada. En un sistema complejo pueden aparecer pequeños errores que coincidirán de maneras sorprendentes, produciendo síntomas difíciles de entender que dificultan el poder diagnosticar el problema en tiempo real. Si, además, el sistema está estrechamente vinculado, ent...

Karen Christensen

Editora de Rotman Management ·